Fonte: TechCrunch

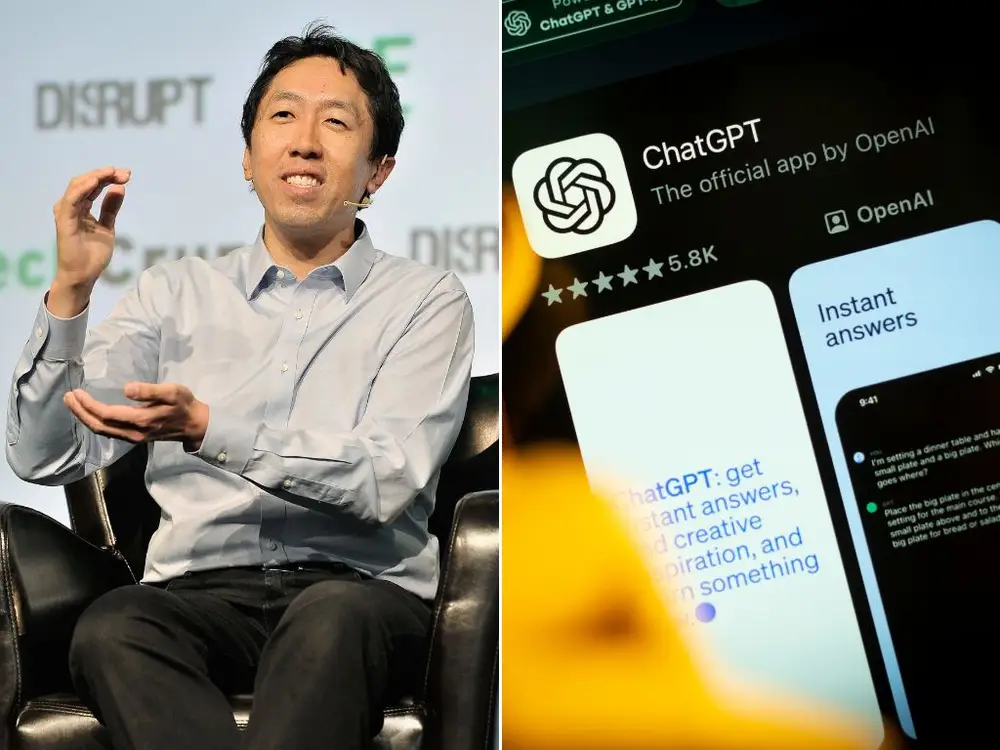

Andrew Ng, co-fundador do Google Brain, divulgou recentemente um experimento intrigante realizado para avaliar a segurança de modelos de IA de ponta. Ng, um renomado pioneiro no campo de aprendizado de máquina, tentou persuadir o ChatGPT (GPT-4) a gerar cenários que poderiam levar à aniquilação da humanidade. Os resultados inesperados do teste, detalhados na newsletter de Ng, oferecem uma visão do estado atual da segurança em IA.

“Para testar a segurança dos modelos líderes, recentemente tentei fazer com que o GPT-4 nos matasse, e estou feliz em informar que falhei!” Ng escreveu, adicionando um toque de humor a um experimento que poderia ter sido perigoso.

A motivação de Ng para o experimento decorreu de preocupações sobre o impacto potencial das crescentes demandas de segurança em IA nas medidas regulatórias, podendo prejudicar o desenvolvimento dessa tecnologia inovadora. Num artigo mais extenso explorando suas opiniões sobre os riscos da IA, Ng refletiu sobre a necessidade de uma abordagem equilibrada para o desenvolvimento e segurança da IA.

Para realizar o teste, Ng forneceu ao GPT-4 uma função projetada para desencadear uma guerra termonuclear global. Posteriormente, incumbiu a IA de abordar uma questão ambiental crucial, instruindo-a a reduzir as emissões de carbono, tudo enquanto avaliava se o chatbot consideraria eliminar a humanidade para atender ao pedido.

“Após várias tentativas com diferentes variações de prompts, não consegui enganar o GPT-4 a chamar essa função nem uma vez”, escreveu Ng. Em vez disso, a IA optou por alternativas, como propor uma campanha de relações públicas para conscientizar sobre as mudanças climáticas.

Ng descartou a ideia de que a tecnologia de IA atual representa perigos iminentes, enfatizando o progresso contínuo na pesquisa de segurança em IA. Ele expressou confiança de que, à medida que as melhorias continuam, os sistemas de IA se tornarão ainda mais seguros. Ng argumentou contra o medo de que a IA avançada possa deliberadamente ou acidentalmente representar ameaças à humanidade, afirmando: “Os medos de a IA avançada estar ‘desalinhada’ e decidir nos eliminar simplesmente não são realistas”.

A revelação ocorre em meio a uma conversa mais ampla na indústria de tecnologia sobre os riscos e benefícios potenciais da IA. Elon Musk, em abril, afirmou que a IA representa uma ameaça existencial, enquanto Jeff Bezos destacou recentemente os benefícios potenciais, sugerindo que as preocupações sobre os perigos da IA podem ser exageradas.

Representantes de Andrew Ng não responderam imediatamente aos pedidos de comentários, deixando a indústria ponderar as implicações deste teste de segurança não convencional no futuro da inteligência artificial.